OpenAI 的春季发布会终于是来了。

没有所谓的 AI 搜索引擎,也没有炸裂的 GPT-5 ,但 OpenAI 还是让大伙儿感受到了,什么叫做“Only OpenAI Can Do”。

就在今天凌晨, OpenAI 的春季发布会终于是来了。

他们也没多讲几句废话,整场发布会就二十来分钟,其中,最重磅的无异于GPT-4o 新模型的发布。

关于 GPT-4o 起名的缘由, OpenAI 官方是这么解释的:“ o “的全称是“ omni ”,也就是“全能”的意思。

之所以说它全能,是因为它能把文本、视觉、音频全打通了。换句话说,你跟 GPT-4o 对话就跟真人似的。

最重要的是, GPT-4o 是免费向用户开放的,不开 Plus 会员也能用,只不过 Plus 会员要多一些使用次数。

反正跟世超一起蹲守直播的同事们看了,都直呼想要。。。

就连奥特曼也在推特上毫不避讳地,把 GPT-4o 跟科幻电影《 Her 》联系起来。(这部电影讲的是人和 AI 语音助理谈恋爱的故事)

评论区的网友们也纷纷表示“见证历史” “电影终于要照进现实了”,甚至还用奥特曼的照片,整出来了个“ him ”。

玩笑归玩笑,但世超觉得, OpenAI 这次 GPT-4o 的现场演示效果,特别是实时语音和视频交互的能力,确实甩了其他现役大模型好几个车尾灯。

不过光这么说,大伙儿对 GPT-4o 的感受可能也不深,咱直接来看演示。

像演示人员让 GPT-4o 从一数到十,中途就嫌它语速太慢了,让它说快点儿, GPT-4o 能立马反应过来,后续随时插话它都能瞬间 get 到。

就这一个接一个的连续对话实力,说实话世超还没在 AI 身上体验过。

给 GPT-4o 一个麦克风和摄像头权限,它能分分钟化身成面试指导官,比方视频里的这个老哥,说自己要去 OpenAI 面试,让 GPT-4o 给点着装建议。

它迅速“打量”了下这位老哥,礼貌不失幽默地给出了“抓个头发”的中肯建议。但老哥打算走个不听劝的人设,顺手拿出个帽子,问能不能戴它去面试。

GPT-4o 这边反应贼快,识破了老哥明知故问地恶作剧,顺着他的话茬说,也不是不行,最起码能让你在人群中脱颖而出。

如果不给世超看演示画面,光听声音我可能会以为,这就是两个朋友之间在开玩笑。

当然,以 GPT-4o 的知识储备和多模态能力,它也有相当正儿八经的应用场景。

一扭头,就能直接化身成视障人士的眼睛,帮他们识别所在的位置,要是想知道眼前都有啥场景, GPT-4o 也能够绘声绘色地描绘出来,甚至还能一步一步指导视障人士打车。

再摇身一变, GPT-4o 还能化身成数学老师,把屏幕的权限开放给它,它能一步步指导你做题,你在题目上写了啥画了啥 GPT-4o 也都能看得一清二楚。

有一说一,这跟世超上中学时爸妈请的家教没啥两样。。。

看完官方的案例视频,相信大伙儿跟世超一样,已经被震撼得没边儿了。

而为了做到这些, OpenAI 在底层的模型上可是下了不少苦功。

之前咱们用 ChatGPT 的语音对话,都是一轮一轮的来。它得先把咱说的话转换成文字输给 GPT-4 ,等 GPT-4 生成文字答案之后,才能再转成语音输出。

也就是说,以前和 ChatGPT 语音对个话,它得动用三个模型,一个管音频转文本,一个 GPT-4 管文本转文本,另外还有一个管文本转音频。

一整套流程下来,耐心都快给磨没了,而且中间除非咱们手动暂停,否则根本没插话的机会。

但 GPT-4o 不一样,它是一个原生的多模态模型,无论文字音频,还是视频啥的,所有的输入和输出都在同一个神经网络里处理。

这种打娘胎里自带多模态的特性,让 GPT-4o 能够听懂好赖话,表达自己的情绪,和它对话也能像吃了德芙一样丝滑。

不过,上面那些视频终归还是“PPT”,没到手实测一波,世超也不敢轻易下定论这玩意儿是不是真的有这么强。毕竟前段时间, Sora 生成的《气球人》短片才被传出加了大量的人类后期。

而在实际用这块, OpenAI 还是一如既往的狗,嘴上说 GPT-4o 都能免费用,但也要分先来后到,而且功能也慢慢开放。

现在能用上 GPT-4o 的只有 Plus 账号,而且最重磅的实时视频和语音功能,毛都看不着。

但有总归比没有强,世超手边恰好也有个 Plus 账号,而且官方也说了,GPT-4o 生成的速度还会比 GPT-4 快上两倍。

所以咱这波,就先提前给差友们试试 GPT-4o 的实力。

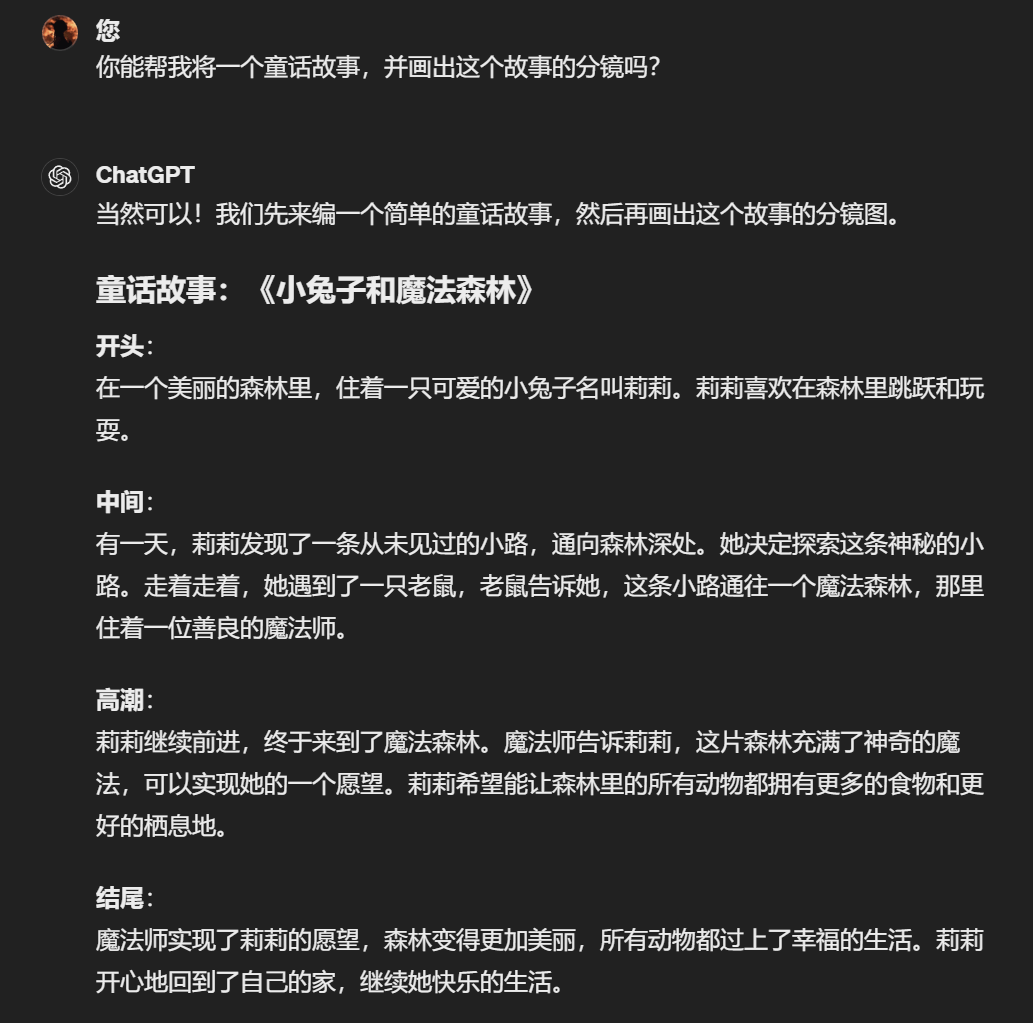

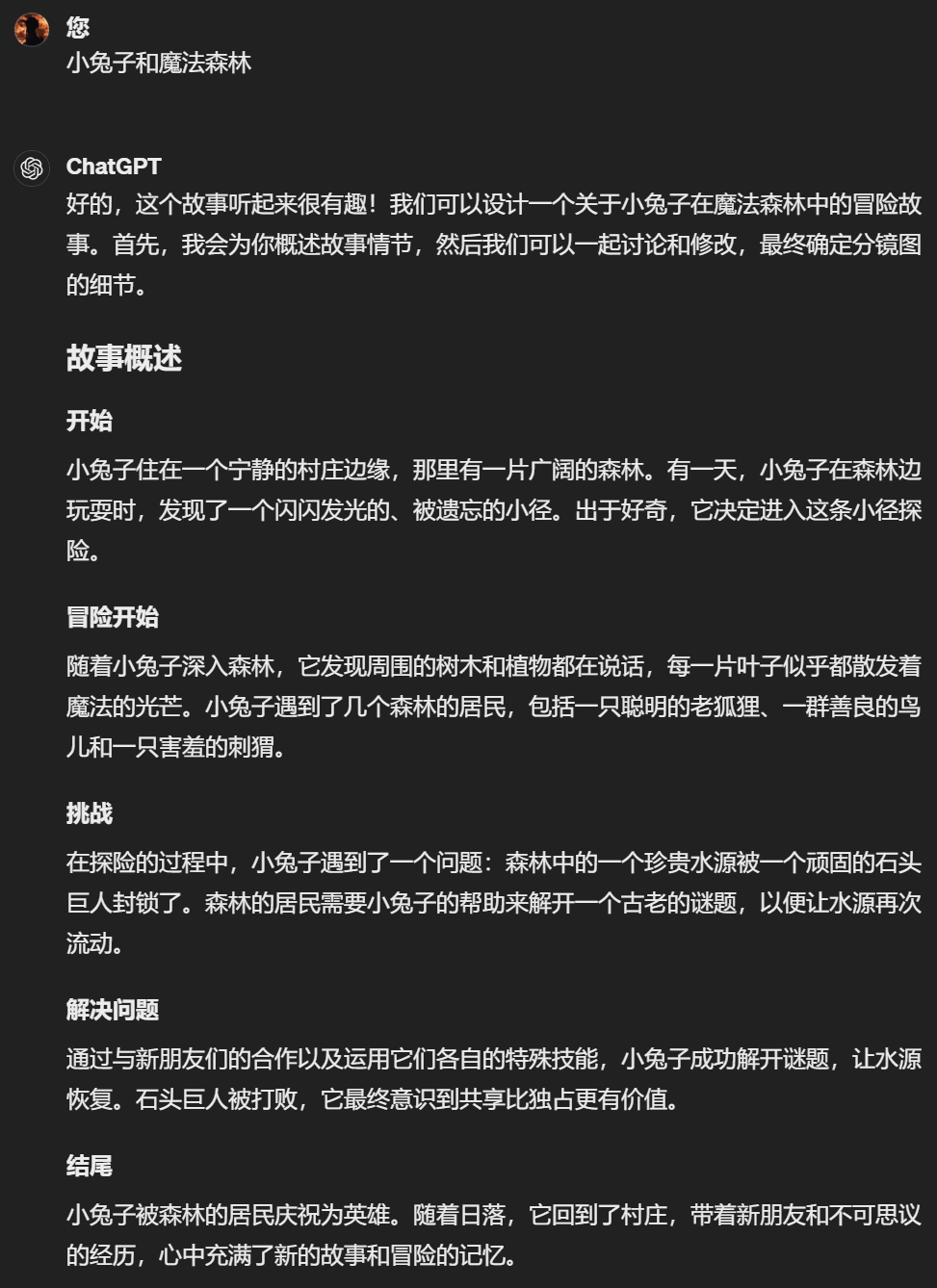

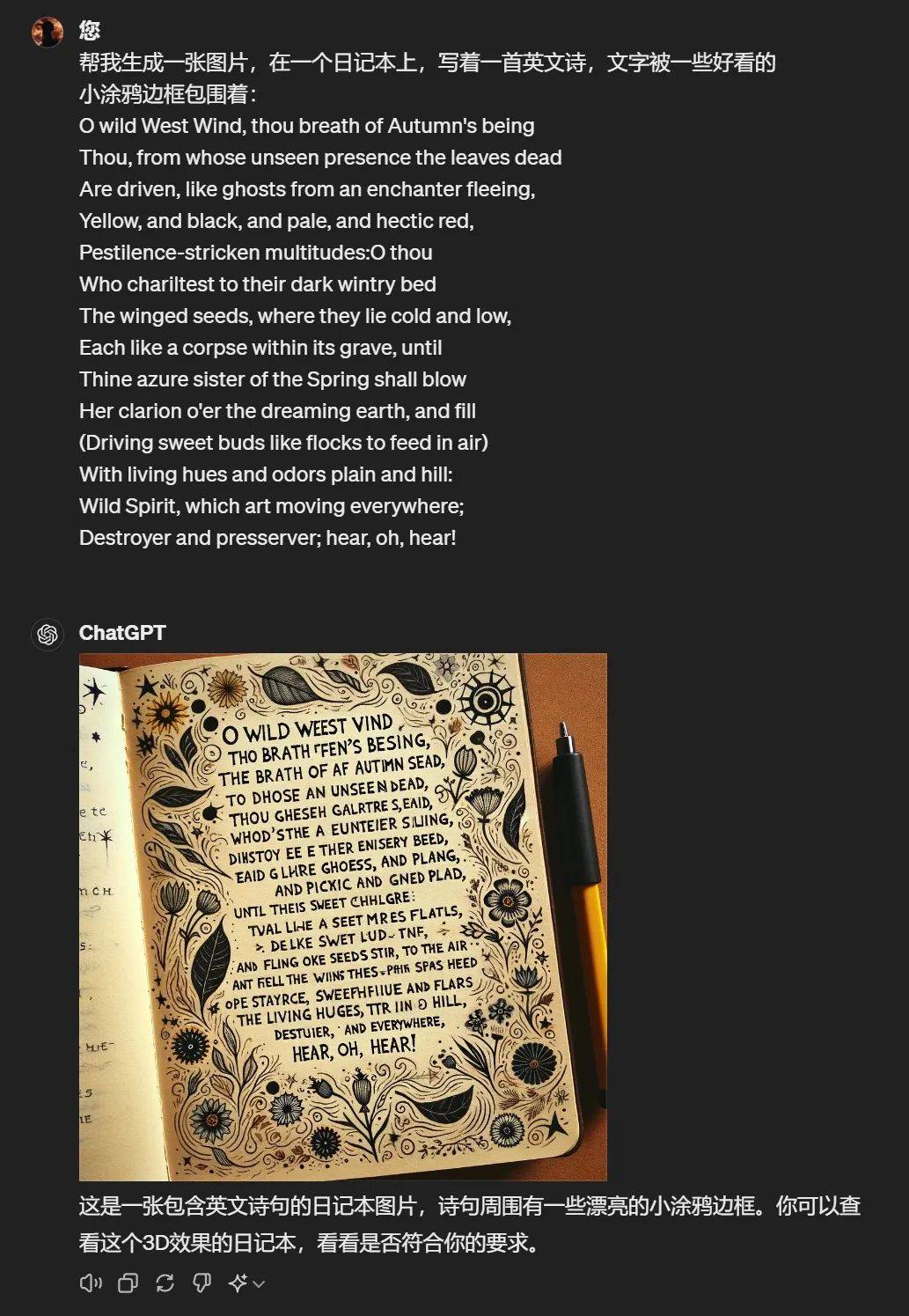

先让它给咱讲一个童话故事,顺便再画出整个故事的分镜图。GPT-4o 没犹豫几秒,库吃库吃就开始写了。

写完中间也没带停顿,直接开始画分镜了。

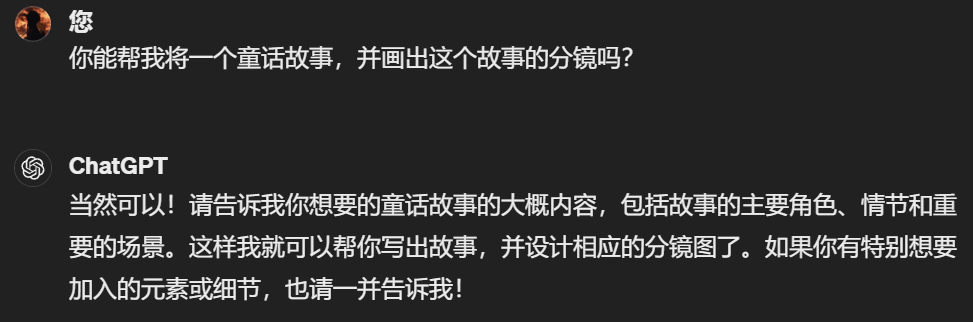

而同样的问题再抛给 GPT-4 ,它一开始就得磨蹭半天在问题上。。。

讲清楚要求后才肯继续写,而且写完之后也不继续画分镜图,还得等世超我再亲自强调一波。

不过虽然 GPT-4 比 GPT-4o 墨迹了不少,但从内容来看,我还是会觉得GPT-4 会更丰富一点。

再借我司老员工火锅的照片一用,分别让 GPT-4 和 GPT-4o 生成一张像素风的图片。

在生成速度上 GPT-4o 完胜,但要抠细节的话两个就半斤八两了。

GPT-4 识别出了火锅嘴里叼着的是袋子, GPT-4o 多识别出了一只拖鞋,非要比的话,其实 GPT-4 的金毛更像火锅一些。。。

(左边GPT-4,右边GPT-4o)

接着,我又让 GPT-4o 把咱差评的 LOGO 换成 3D 图片,结果它整出来字,翻遍整本新华字典,估计都找不到。

但不识汉字也是历代 ChatGPT 的老毛病了,换成英文再要求它,你别说,这次出来的整体效果还可以,就是经不起细看,不少英文拼写都是错的。。

整个上手试下来, GPT-4o 给我最大的印象就是快,非常快。

但说实话,除了快,世超真没觉得有啥特别的了,与其说 GPT-4o 是 GPT-4 的智商进化版,倒不如说是把 GPT-4 的交互能力单拎出来强化了一波。

就像奥特曼在博客里提到的,“达到人类响应时间和表达水平”是 AI 的巨大变化。大模型的终极形态,也应该是让人和 AI 的交流回归到最原始、最简单的形态。

在未来,咱们面对一台电脑、一部手机,直接说话交流,就是最主要的交互方式。

不过这次 GPT-4o 最厉害的杀手锏:视频交流功能,还没放出来,等到时候咱能体验到了再下结论也不迟。

另外,网友们也没干坐着,也在各种研究 GPT-4o 的,结果,却扒出了一些番外的料。。。

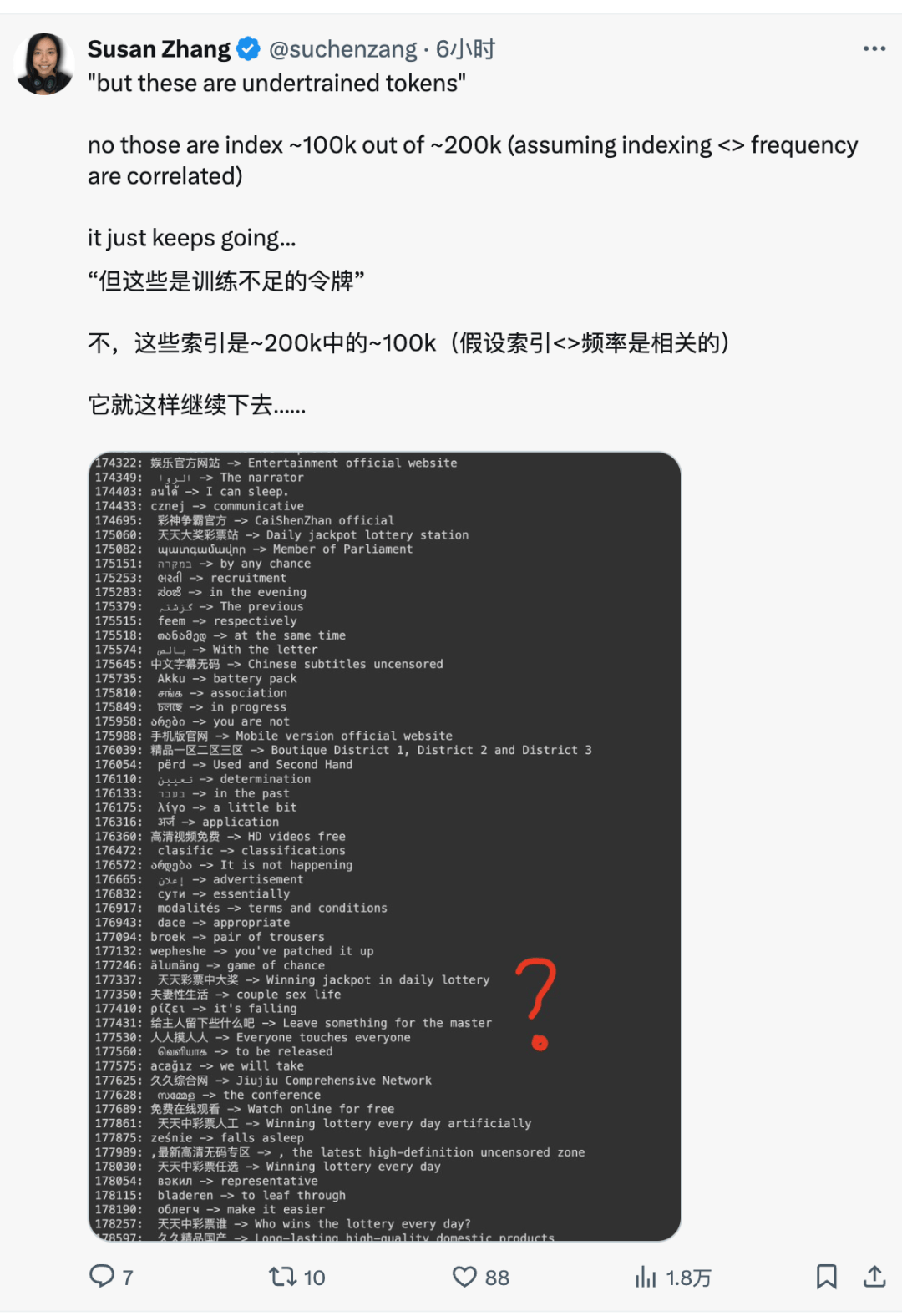

也不知道 GPT-4o 的中文语料库是哪儿来的,里面有不少的钓鱼网站的违禁词,像什么“日本 x 片免费视频”这类的。

给人老外都整无语了。。

像这样的乐子,以后指不定还要冒出来不少。但言归正传, GPT-4o 的出现确实又给 AI 开了个新副本。

按照之前 ChatGPT 问世之后,其他友商步步紧逼的尿性。世超盲猜,在 GPT-4o 之后,类似的“Claude-o”“Gemini-o”应该很快就会出现。

刚好明天就是谷歌的 I/O 了,咱们也浅浅期待一手好吧。

撰文:西西&松鼠编辑:江江&面线封面:萱萱

图片、资料来源:

X,OpenAI、Blog