科技进步的速度和力度,再一次让人震撼。

观点 / 刘润 主笔 / 尤安 责编 / 李桑

这是刘润公众号的第1841篇原创文章

昨天,一觉起来,美国的OpenAI正式官宣了大模型GPT-4 。

距离上次基于GPT -3.5的ChatGPT的推出,才刚刚过去105天。

科技进步的速度和力度,再一次让人震撼。

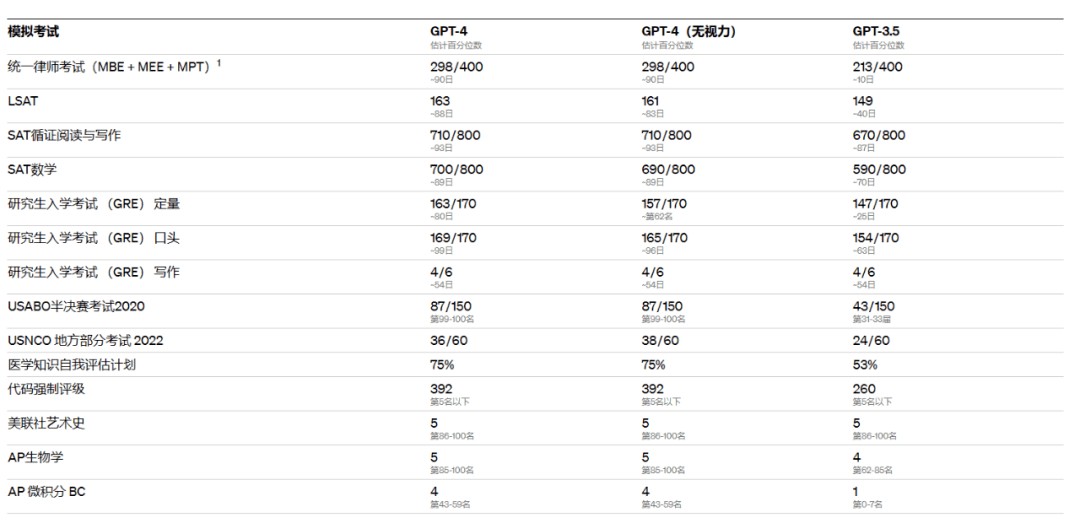

好像刚感叹完GPT -3.5通过谷歌程序员面试,GPT -4就已经把美国的模拟律师资格考试都考到前10%了。

转战到考场,也能把美国高考题(SAT考试),做出可以进哈佛的成绩。

甚至,还展现出了识图方面的巨大潜力。

我们总认为,不着急,还有很多AI做不到。

但是,AI一项一项,都做到了,而且是以超乎人们想象的水平做到。

于是,很多人开始着急,急着寻找机会。

但是在寻找机会之前,建议你,一定沉下心,再看一看。

看懂这个席卷了我们一次又一次的GPT,到底是什么?

GPT-4

已知,GPT -4,应该比GPT -3.5厉害。但是,到底厉害在哪儿?

GPT -4正式发布前,有2个猜测:

1, GPT-4的机器学习参数,将从1750亿个,增加到100万亿个。能力差距,堪比一个 月薪1750元的人,和一个月薪100万元的人。

2, GPT-4将支持多模态,也就是文字、图片、音频,甚至视频等。能力差距,堪比一个 聋哑且盲的人,和一个耳聪目明的人。

相当震撼的猜测。

而openAI的老板Sam对此的回应是:一派胡言(complete bullshit)。

真的是一派胡言吗?

实际发布的结果是:GPT-4的能力,看起来确实提升了。

但是:

1,具体学习参数,没公布。OpenAI只给这次迭代定了个性: “GPT-4比GPT-3.5更可靠、更有创造力,并且能够处理更加细致复杂的指令”。

2,支持多模态,但是就多了一个图片,并且只支持你输入图片,轮到GPT输出时,依然只打字回你。

进步的步子迈多大,不明确,但大方向,却是大致准确的。

要真正理解GPT,这2个大方向,建议你真的看懂:大模型,多模态。

先说说,这次GPT-4最亮眼的更新:多模态。

多模态,很了不起吗?

多模态

多模态是什么?

想象一下,同事忽然发你一句微信消息:“嘘,王总在你后面。”

你收到后马上回头,看到王总,打了一声招呼:“王总。”

这件事,要做到,很了不起吗?

很了不起。短短几秒钟,你一口气处理了文字、声音、图像等多种信息数据。

多模态,就是多种信息数据的模式和形态。

而这些种类不同的信息数据,比如你在消息里认出的文字,回头看到的一个图像,嘴里说出的一段声音,有时还指向同一个信息:“王总”。

对你来说,在多模态中识别和对应出同一个“王总” ,很简单,好像没什么了不起。

但对GPT来说,却是一个远大的理想:跨越多个模态,处理更复杂的任务。

这个理想,为什么远大?

因为,要做到,你首先得有眼睛和耳朵。

升级前的ChatGPT,只能摸索着,用文字和你交流。

但升级为GPT-4后,ChatGPT从此有了“眼睛 ”。

你发它一张图片,它能“看到”,还能“看懂”,并以此为基础,帮你处理更多任务。比如,帮你P掉“王总”。

这,就是多模态之于 GPT-4的意义:进化出了眼睛。

了不起。但,这还不是 GPT-4进化的全部。

大模型

另一个被频繁提起的进步,是 GPT-4的基本功——语言能力。

短短105天,GPT的语言模型,又得到了新一轮的进化。

一方面,“单词最大输出限制”,提高到了 25000 个单词。

原来,给它处理一篇文章,稍微字多点都不一定能发完整,现在,很多人甚至直接丢网页、PDF给它处理。

并且,在理解和回答问题,尤其是比较复杂的问题时, GPT-4也显得更聪明了。

怎么变聪明的?

简单来说,就是GPT-4的“大脑”变得更大,“神经元”变得更多了。

2018年的GPT,参数量是1.17亿。

2019年的GPT-2,参数量是15亿。

2020年的GPT-3,乃至后来基于GPT-3.5的ChatGPT,参数量是1750亿。

昨天发布的GPT-4,虽然官方没有公布具体参数量,但也没人会小看它的参数量。

GPT一出手,就是以亿为单位的参数量。而且每年还在疯狂翻倍。

这,就是提到GPT时,总会提到的“大模型”。

大量的参数,就像大量的神经元,这往往也意味着,更大概率能“猜中你想要的答案”。

人们常常把这种特点,称为:“聪明”。

GPT-4部分成绩单

想想这种量级的参数量,再看看GPT-4那些“碾压”人类的考试成绩单,似乎也能心理平衡了。

虽然,还是不太好接受:难道,要聪明到可以碾压90%的人类,只需要参数量够“大”就行了吗?

没那么简单。

训练

你有没有想过,当你打开ChatGPT的对话框,打出一个问题时,屏幕那边的ChatGPT,是怎么做这道题的?

比如你在对话框里问: “床前明月光,下一句是什么?”

作为一个人工智能,而不是人,ChatGPT从一开始,答题的路子,可能就和你完全不一样:

它根本不回忆,而是转头就去网上抓数据。看看都有哪些地方出现了“床前明月光”。

再用它那同时“考虑”上亿个参数的“脑子”算一件事:

排在这句之后的字,都有哪些?根据上下文,这些字是正确答案的概率都有多高?

然后转头就把算出来概率最高的文字,选出来,在对话框里回复你。

找组合,算概率,比大小。

你问的是语文题,它做的是数学题。

因为做数学题,才是模型的本质。

那,会不会做错呢?

会。如果,它从网上找的数据样本,刚好是一些错误很多的盗版书,最后通过计算,回复你的是“洒了一碗汤”,怎么办?

显然,模型并不在乎对错,但是人类在乎。

这时,人类就会做一件事:优化它,训练它。

怎么训练?

不如回想下,你是怎么做出这道题的?

首先你先在课本上看到过这首诗。

然后,再做过一些练习题。做完后对答案,有人告诉你对还是错。

对了,加分,你开心,从此记住答案是这个。

错了,扣分,你难过,再去找正确答案。

GPT,也差不多。

先“看书”,输入庞大的数据。

然后“做题”,并得到“反馈”。

做对,加分。做错,扣分。

和你不一样的是,AI不会开心和难过。

但,谁不喜欢分数高呢?

几亿个参数和相应的权重值都会根据这种分数反馈,再调整,再调整。

直到无限趋近于准确。

听起来是不是很完美?但,却有一个重大的难点。

成本

训练,是需要成本的。

参数量有多惊人,成本就有多惊人。

当一个需要同时“考虑”上千亿,甚至更多参数的“大脑”运转起来时,会需要哪些成本?

首先,每次训练,都能花掉上海几套房。

有数据显示,训练一次以GPT-3.5为模型的ChatGPT模型的成本,都要460万到500万美元。

此外,要入局GPT这种级别的产品,“入场券”也非常昂贵。

比如要达到相应的算力,光更早的GPT-3在训练中,都需要用到1万枚英伟达GPU芯片。

以目前比较主流的英伟达A100芯片为例,一颗价格约8万元。

每颗8万元, 1万颗,一开局光是芯片的花费,都要8亿元以上。

如果看到这还有勇气考虑,不妨参考ChatGPT的公司OpenAI。

OpenAI在之前基于GPT-3.5的ChatGPT上,就至少付了2大笔钱:

交给“机房”的钱,比如算力和数据,就要近20亿元。

交给“人”的钱,比如科学家、工程师的工资,也要近5亿人民币。

这,还不算每天可能高达几万美金的电费。

而新出来的GPT-4, 作为“更聪明”的“大脑”,算力成本可能又是一个新的台阶。

这些,都是“聪明”的价格。

如此昂贵,却总有人愿意付。

最后的话

比如,陆续投资了ChatGPT近900亿人民币的微软。

微软的必应搜索,在目前的全球搜索引擎市场中,份额占比为个位数,排在它前面的,是份额占比超90%的Google。

但是,在搭载了ChatGPT后,必应在它的搜索框里,昂首挺胸地设置了这么一句话:

Ask me anything…

昨天,GPT-4发布后,微软更是骄傲地宣布:

新版必应搜索,已经在更早,就用上了GPT-4,过去五周中很多人体验的必应就是GPT-4加强过的。

今天,百度也正式发布了文心一言。

它会成长为中国的OpenAI吗?

现在,还不知道。

中国,会有属于自己的GPT-4吗?

现在,也还不知道。

但是可以明确知道的是:不容易。

数据不容易,芯片也不容易。

但是,我们面对这种不容易的情况,还少吗?

以前怎么办,现在就怎么办。

祝福。

《 战略,要有计划、有执行 》